Man könnte meinen, ich kaufe und verkaufe ständig Mini-PCs – und so ist es auch. Aber es hat Gründe, warum mit dem Minisforum UM690L Slim das nächste Exemplar auf meinen Schreibtisch steht: Mir fehlt was Privates.

(mehr …)Blog

-

GMKtec NucBox G5 N97 Mini-PC

Ich hab wieder einen Mini-PC gekauft. Diesmal den GMKtec NucBox G5 mit Intel Alder Lake N97 CPU. Nach nur einem Monat geht er zu eBay, ich erkläre warum das nicht am Gerät liegt.

(mehr …) -

Intel NUC12WSKi5 Slim

Vom Gaming PC zu PlayStation 5 und leisem Mini-PC, das war unverändert das Ziel. Der erste Versuch mit einem Minisforum EliteMini TH80 sah vielversprechend aus, aber letztendlich war ein Wechsel notwendig: Zu einem Intel NUC12WSKi5 mit Core i5-1240P im „Slim“ Format.

(mehr …) -

Minisforum Elite Mini TH80

Zu Ende 2022 habe ich eine Entscheidung getroffen: Statt den in die Jahre gekommenen Gaming-PC aufzurüsten wurde dieser entsorgt und durch einen kleinen, kompakten Office-PC ersetzt – den Minisforum Elite Mini TH80. Gut, dass die Playstation 5 bereits vorhanden war.

(mehr …) -

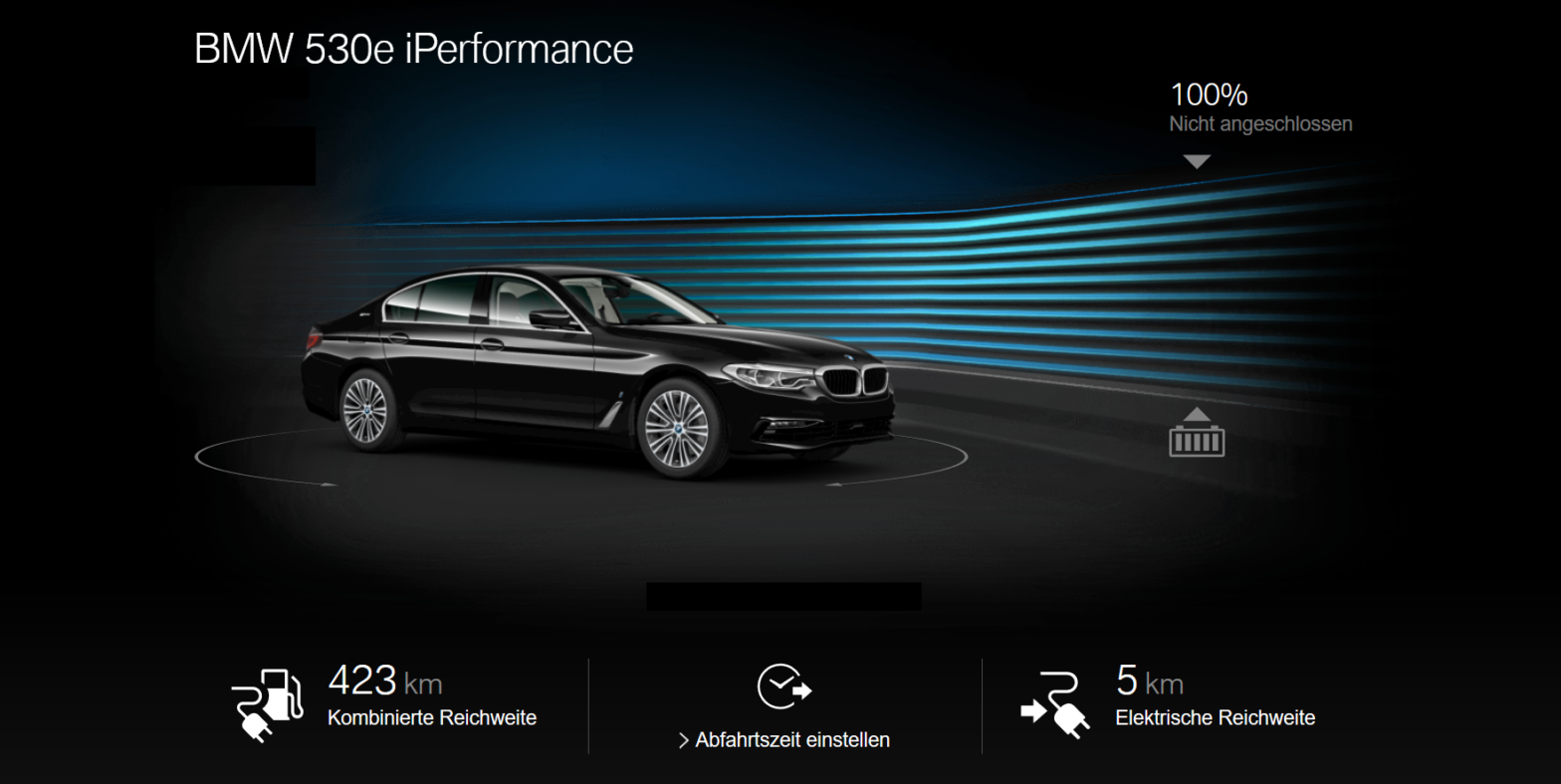

BMW 530e iPerformance: Fazit nach 3 Jahren

Drei Jahre habe ich jetzt einen BMW 530e iPerformance, also ein Plugin Hybrid Electric Vehicle (PHEV) als Dienstwagen fahren dürfen. Gestern war die Rückgabe bzw. der Wechsel gegen ein neues Auto. Obwohl das Neue stets der Feind des Guten ist, blicke ich mit ein wenig Wehmut auf die Zeit mit dem 530e zurück.

(mehr …) -

Linux Software RAID – Festplatte(n) tauschen

(mehr …)Corona hat mich erwischt, mit mäßigen Auswirkungen. Und die M2 SSD in meinem Server ist „geplatzt“, mit deutlichen Auswirkungen. Und eine der beiden HDDs im RAID1 sagt ihren nahenden Tod via S.M.A.R.T.-Warnung voraus – zumindest das soll ohne Auswirkungen bleiben.

-

Neue Hardware für den Zigbee-Hub und Home Assistant

Vor fast 2 Jahren habe ich mich erstmals bewusst mit der Zigbee-Technologie und ihrer Integration in Home Assistant (HA) beschäftigt. Die seinerzeit gewählte Hardware und Software haben weitestgehend einwandfrei ihren Dienst verrichtet. Doch wiederkehrende Probleme wecken den Wunsch nach Veränderung, Probleme, die mit neuer Hardware und alter Software adressiert werden sollen …

(mehr …) -

Zigbee Hub mit Raspberry Pi und Raspbee II

Auch wenn das Jahr 2020 in Summe besser abgeschrieben wird, das ein oder andere Vorhaben konnte dennoch umgesetzt werden. Und so kam es diesmal zu einem „funktionalen“ Weihnachtsgeschenk an meine Eltern: Die Vorbereitung für ein „Smart Home“ auf Basis von Home-Assistant, Phoscons Raspbee II-Modul und des Zigbee Protokolls.

(mehr …) -

ASRock DeskMini A300

Seit einigen Jahren dient ein HP ProLiant N54L Microserver mir als „Heimserver“. Ein grundsolides Gerät, leise, wartungsarm, stabil. Die AMD Turion II CPU ist allerdings festverlötet und stößt mit ihren 2,2 GHz an ihre Grenzen, ebenso wie die max. 8 GB RAM. Zeit für etwas Neues, stärker, größer – und kleiner: Der ASRock DeskMini A300.

(mehr …) -

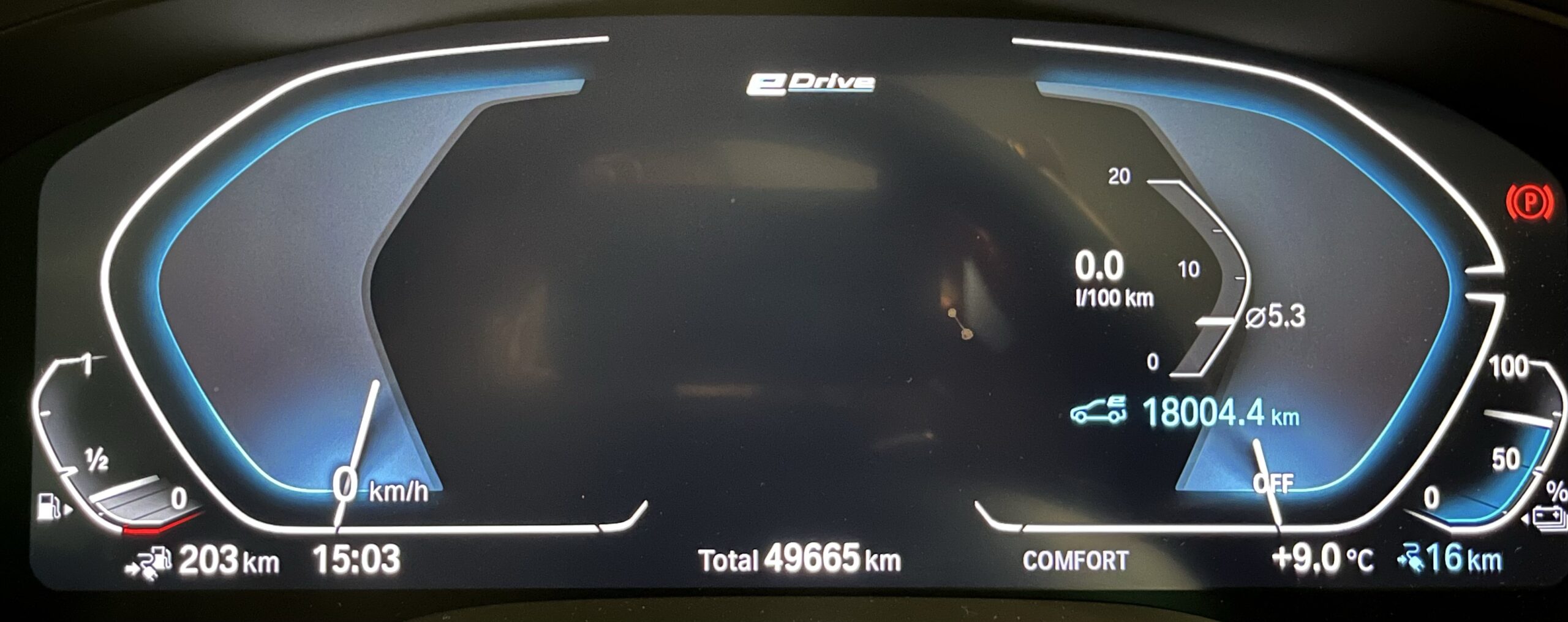

BMW 530e iPerformance: Die ersten 10.000km

Seit Anfang Dezember fahre ich ein teil-elektrifiziertes Fahrzeug, konkret einen BMW 530e iPerformance, Modelljahr 2019. Jetzt, gut 9 Wochen später sind die ersten 10.000 Kilometer „abgespult“. Zeit für ein erstes, wie immer subjektives Zwischen-Fazit.

(mehr …)